Demander le programme !

Contenu :

-

Graphe orienté pondéré associé à une chaîne de Markov à deux ou trois états.

-

Chaîne de Markov à deux ou trois états. Distribution initiale, représentée par une matrice ligne $\pi_0$. Matrice de transition, graphe pondéré associé.

-

Pour une chaîne de Markov à deux ou trois états de matrice $𝑃$, interprétation du coefficient $(𝑖,𝑗)$ de $𝑃_𝑛$. Distribution après 𝑛 transitions, représentée comme la matrice ligne $\pi_0 P_n$.

-

Distributions invariantes d’une chaîne de Markov à deux ou trois états.

Capacités attendues

-

Associer un graphe orienté pondéré à une chaîne de Markov à deux ou trois états.

-

Utiliser le calcul matriciel pour étudier une chaîne de Markov à deux ou trois états (calculer des probabilités, déterminer une probabilité invariante).

Démonstrations

-

Expression du nombre de chemins de longueur $𝑛$ reliant deux sommets d'un graphe à l’aide de la puissance $𝑛$-ième de la matrice d’adjacence.

-

Pour une chaîne de Markov, expression de la probabilité de passer de l’état $𝑖$ à l'état $𝑗$ en $𝑛$ transitions, de la matrice ligne représentant la distribution après $𝑛$ transitions.

Chaîne de Markov

Exemple introductif

Lors d'un travail de recherche, un étudiant lit différentes pages internet. Ils passent d'une page à l'autre à partir des liens hypertexte.

Cet étudiant juge la page soit pertinente, soit non pertinente.

L'expérience acquise au cours de ce type de recherche permet de prévoir que si :

-

si une page est pertinente, la suivante a une probabilité égale à 0.6 d'être elle aussi pertinente,

-

si une page est non pertinente, la suivante a une probabilité égale à 0.9 d'être non pertinente,

On note $V_n$ l'événement "la $n$-ième page est pertinente".

On suppose que la première page est pertinente.

-

Modéliser le parcours sur les trois premières pages de la recherche par un arbre de probabilité en utilisant la notation $V_n$.

-

Compléter cet arbre pour illustrer le parcours sur les $n$ premières pages.

-

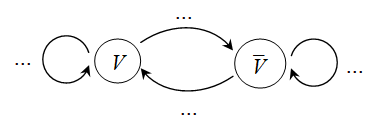

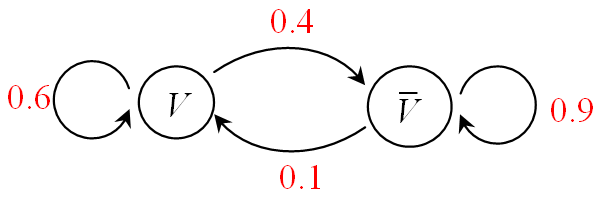

Plutôt que d'utiliser un tel arbre, on peut modéliser la situation par un graphe probabiliste comme celui-ci dessous où $V$ correspond à l'événement "la page est pertinente" et où toute flèche correspond au passage à une page suivante.

Le reproduire et le compléter.

Vocabulaire sur les graphes

Un graphe orienté est pondéré lorsque chaque arête est affectée d'un nombre réel positif appelé poids de cette arête.

Un graphe probabiliste est un graphe orienté où tous les poids sont des réels compris entre 0 et 1 et tel que la somme des poids des arêtes issues d'un même sommet est 1.

-

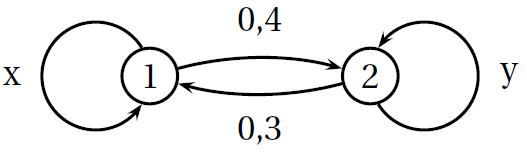

Déterminer les valeurs de $x$ et de $y$ pour que le graphe ci-dessous soit un graphe probabiliste.

-

Est-ce un graphe probabiliste ? Pourquoi ?

matrice associée

La matrice associée à un graphe probabiliste comportant $k$ sommets d'appelle une matrice de transition.

Cette matrice de transition est une matrice carrée d'ordre $k$ où le terme de la $i$-ième ligne et de la $j$-ième colonne est égale au poids de l'arête allant du sommet $i$ au sommet $j$ si elle existe, 0 sinon.

On reprend l'exemple introductif. On avez vu que le problème concret peut être modéliser par le graphe

probabiliste suivant :

-

En considérant comme ordre de sommet "$V$ puis $\overline{V}$", donner la matrice de transition associée à ce graphe probabiliste.

-

Que remarquez-vous sur les coefficients d'une même ligne de cette matrice de transition ?

La somme des termes appartenant à la même ligne d'une matrice de transition vaut toujours 1.

-

Recopier et compléter la matrice de transition $T$ ci-dessous.

$T=\begin{pmatrix} ...&0.6&0.1 \\ 1&...&...\\ ...&0.3&0.5 \end{pmatrix}$ -

En notant les sommets dans cet ordre $A$, $B$, $C$, proposer un graphe probabiliste qui correspond à cette matrice de transition.

Chaîne de Markov

Revenons à l'exemple introductif. On considère la suite de la pertinence des pages visitées.

Pour chaque page, il n'y a que deux possibilités :

-

$V$ : "page pertinente",

-

$\overline{V}$ : "page non pertinente".

Voici des exemples possibles de telle suite, sachant que l'on a supposé que la première page est forcément pertinente :

-

$(V,V,\overline{V},V,\overline{V},\overline{V},\overline{V},\overline{V},\overline{V},V,...)$

-

$(V,V,V,\overline{V},\overline{V},\overline{V},V,V,\overline{V},\overline{V},...)$

Nous avons supposé que la probabilité qu'une page soit pertinente ne dépend que de la pertinence ou non de la page précédente.

On peut voir cela d'une autre manière : lorsque l'on est sur une page, la pertinence de la page future ne dépend pas des pages passées, mais

seulement de celle actuelle.

Nous avons aussi supposé que les probabilités pour passer d'un état de pertinence à un autre sont indépendantes du nombre de pages déjà visitées.

Une chaîne de Markov est une suite $(X_n)$ de variables aléatoires modélisant l'évolution par étapes successives d'un système aléatoire comportant différents états telle que :

-

pour tout état $E_i$, l'événement ${X_{n+1}=E_i}$ ne dépend que de l'état de la variable aléatoire $X_n$ : le futur ne dépend que de l'instant présent.

-

la probabilité de passer de l'état $E_i$ à l'état $E_j$ ne dépend pas de $n$ : l'évolution est constante dans le temps.

À l'étape $n=0$, la probabilité de $X_0$ s'appelle la distribution initiale du système, souvent notée

$\pi_0$.

Dans le cas de $k$ états différents, $\pi_0 = (P(X_0)=E_1\ P(X_0)=E_2\ ...\ P(X_0)=E_k)$.

À l'étape $n$, la probabilité de $X_n$ s'appelle la distribution après $n$ transitions, , souvent notée

$\pi_n$.

Dans le cas de $k$ états différents, $\pi_n = (P(X_n)=E_1\ P(X_n)=E_2\ ...\ P(X_n)=E_k)$.

On peut associer à toute chaîne de Markov :

-

un graphe probabiliste où les sommets sont les états du système aléatoire et où le poids de chaque arête est égal à la probabilité (constante dans le temps) de transition d'un état à un autre,

-

la matrice de transition de ce graphe probabiliste.

On considère un pays subissant une épidémie ; ses habitants peuvent être dans trois états :

-

$S$ : "sain",

-

$M$ : "malade",

-

$I$ : "immunisé".

Des études montrent que, d'un mois à l'autre, chaque habitant peut voir son état changer selon les règles suivantes :

-

s'il est sain, il le reste avec une probabilité de 0.8 et tombe malade avec une probabilité de 0.2,

-

s'il est malade, il le reste avec une probabilité de 0.1 et devient sinon immunisé,

-

s'il est immunisé, il le reste avec une probabilité de 0.7 et devient sain avec une probabilité de 0.3.

Au début de l'épidémie, 2% de la population est malade et 1% est immunisée.

-

Quel est l'ensemble des états possibles ?

-

Justifier que l'évolution de l'état d'un individu mois par mois peut être modélisé par une chaîne de Markov.

-

Proposer le graphe probabiliste associé à cette chaîne de Markov.

-

Proposer la matrice de transition $T$ associée (en conservant l'ordre alphabétique).

-

Déterminer la distribution initiale $P_0$ du système.

-

Que représente concrètement les coefficients obtenus par le calcul $ P_0 T$ ?

Évolution d'une chaîne de Markov

On considère dans cette partie une chaine de Markov $(X_n)$ dont la matrice de transition est notée $T$.

On note $P_n$ la distribution après $n$ transitions écrite sous forme d'une matrice ligne ayant autant de colonne que d'états différents

et telle que le terme de la $j$-ième colonne est la probabilité qu'à l'étape $n$ la variable $X_n$ soit égale à l'état $E_j$.

Ainsi, pour tout entier naturel non nul $n$, on note : $P_n=\begin{pmatrix} P(X_n=E_1)&...&P(X_n=E_j)&...&P(X_n=E_k) \end{pmatrix}$ si $k$ est

le nombre d'états.

Pour tout entier naturel non nul $n$, $P_{n+1}=P_n\times T$.

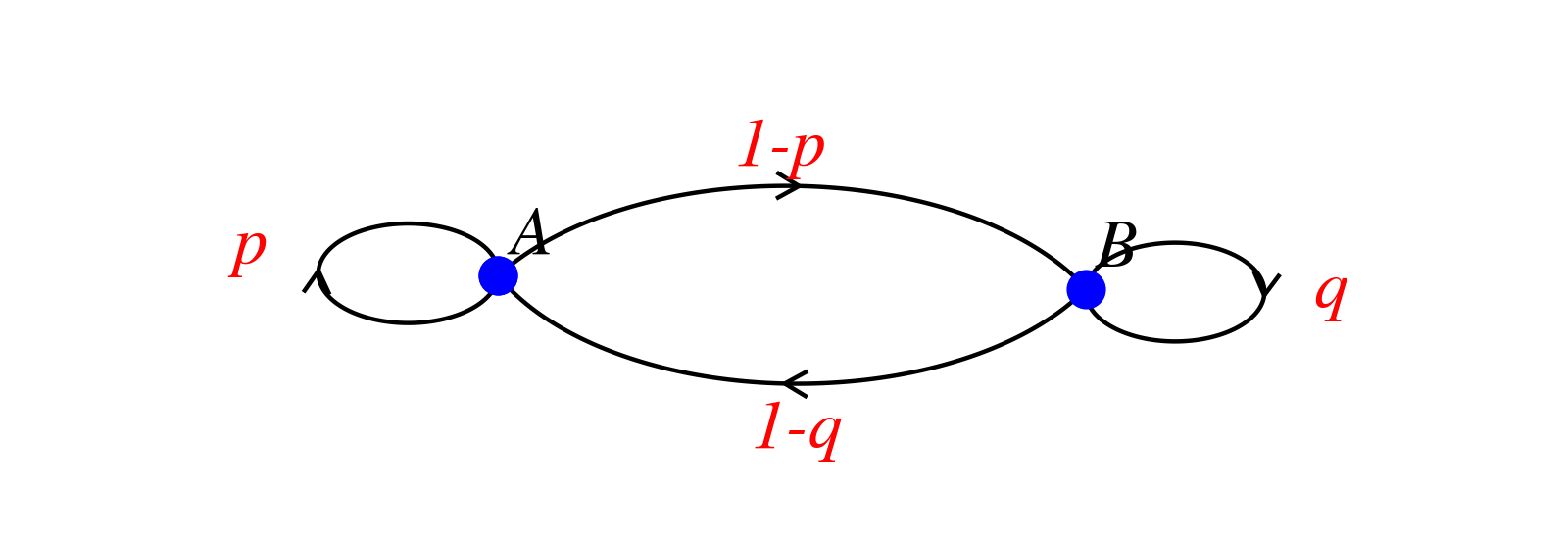

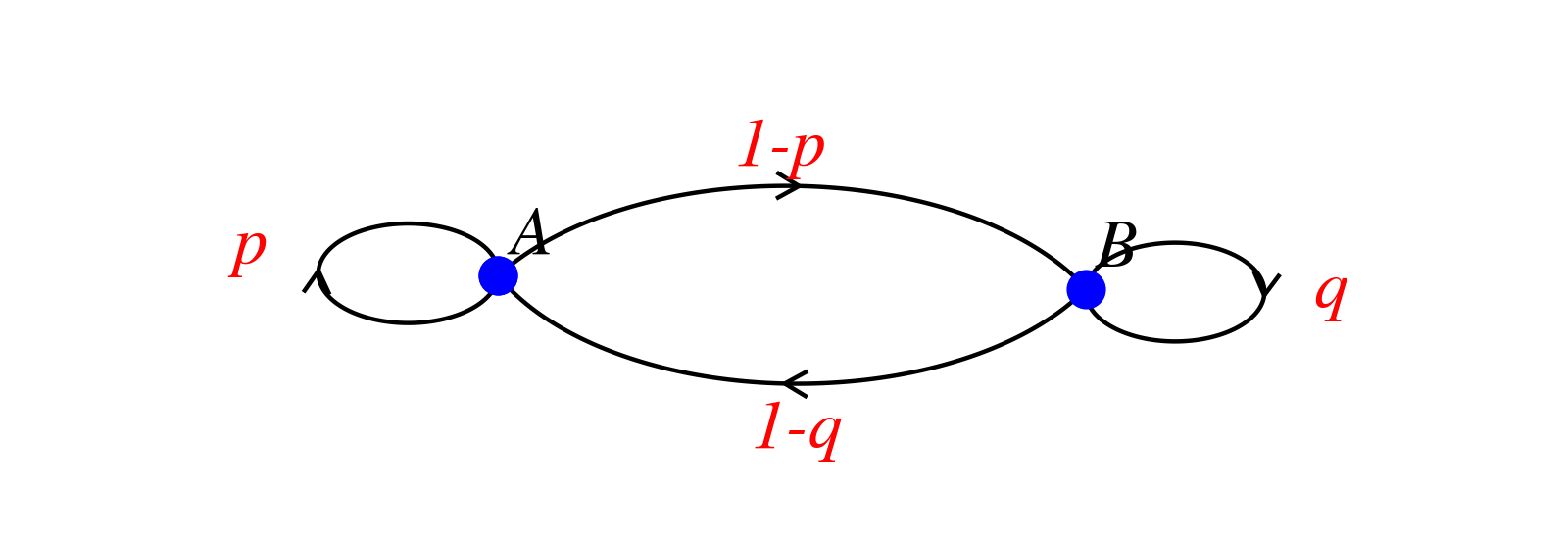

On considère ici une chaîne de Markov à deux états $A$ et $B$ dont voici le graphe associée :

On considère ici que $0\le p \le1$ et $0\le q \le 1$.

On considère ici que $0\le p \le1$ et $0\le q \le 1$.

La matrice associée est donc : $T=\begin{pmatrix} p&1-p \\1-q&q \end{pmatrix}$

On note $P_n=\begin{pmatrix} P(X_n=A)&P(X_n=B) \end{pmatrix}$ la distribution après $n$ transitions et $P_{n+1}=\begin{pmatrix} P(X_{n+1}=A)&P(X_{n+1}=B) \end{pmatrix}$ la distribution après $n+1$ transitions.

-

Développer le produit matriciel $P_n\times T$.

-

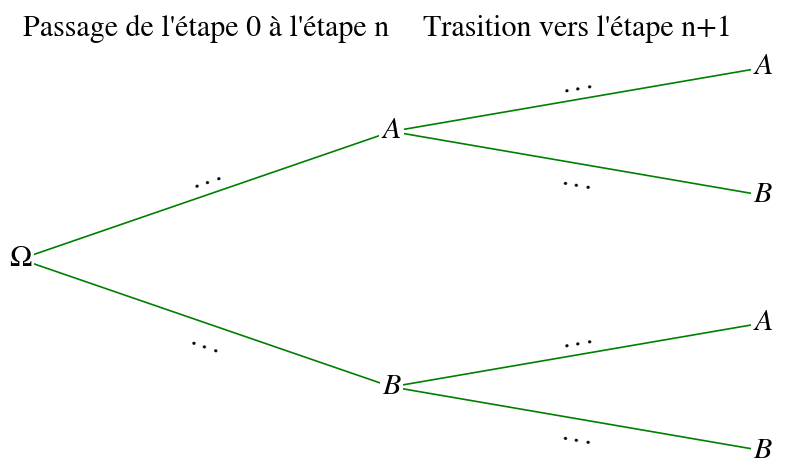

Compléter l'arbre de probabilité suivant :

-

En déduire l'expression de $P_{n+1}$ en fonction de $P(X_n=A)$ et de $P(X_n=B)$.

-

Conclure.

Pour tout état $E_i$ et $E_j$ et pour tout entier naturel $n\ge 1$, le coefficient de la ligne $i$ et de la colonne $j$ de la matrice $T^n$ est la probabilité de passer de l'état $E_i$ à celui $E_j$ en $n$ transitions.

On considère ici une chaîne de Markov à deux états $A$ et $B$ dont voici le graphe associée :

On considère ici que $0\le p \le1$ et $0\le q \le 1$.

On considère ici que $0\le p \le1$ et $0\le q \le 1$.

La matrice associée est donc : $T=\begin{pmatrix} p&1-p \\1-q&q \end{pmatrix}$

On note $P_n=\begin{pmatrix} P(X_n=A)&P(X_n=B) \end{pmatrix}$ la distribution après $n$ transitions et $P_{n+1}=\begin{pmatrix} P(X_{n+1}=A)&P(X_{n+1}=B) \end{pmatrix}$ la distribution après $n+1$ transitions.

Voici une démonstration de ce théorème avec quelques éléments à préciser.

Commencer par lire la démonstration ci-dessous avant de répondre aux questions qui suivent :

Montrons par récurrence que la propriété "le coefficient de la ligne $i$ et de la colonne $j$ de la matrice $T^n$ est la probabilité de passer de l'état $E_i$ à celui $E_j$ en $n$ transitions" est vraie pour tout entier naturel $n$ non nul.

Initialisation : pour $n=1$ :

Par définition de la matrice $T$, le coefficient $T_{ij}$ est la probabilité de passer de l'état $E_i$ à celui

$E_j$ en une transition : $T_{ij}=P_{(X_0=E_i)}(X_{1}=E_j)$.

La propriété est donc vraie au rang initial.

Hérédité : considérons un entier $k\ge 1$ tel que "le coefficient de la ligne $i$ et de la colonne $j$

de la matrice $T^k$ est la probabilité de passer de l'état $E_i$ à celui $E_j$ en $k$ transitions".

Montrons que "le coefficient de la ligne $i$ et de la colonne $j$ de la matrice

$T^{k+1}$ est la probabilité de passer de l'état $E_i$ à celui $E_j$ en $k+1$ transitions".

Soient $E_i$ et $E_j$ deux des états possibles ($A$ ou $B$ ici).

Par hypothèse de récurrence :

$T^k = \begin{pmatrix} P_{(X_0=A)}(X_{k}=A) &P_{(X_0=A)}(X_{k}=B) \\ P_{(X_0=B)}(X_{k}=A)& P_{(X_0=B)}(X_{k}=B)\end{pmatrix}$

puisque le coefficient $T^k_{ij}$ est la probabilité de passer de l'état $E_i$ à celui

$E_j$ en $k$ transitions : $T^k_{ij}=P_{(X_0=E_i)}(X_{k}=E_j)$.

On va calculer la probabilité de passer de l'état $E_i$ à celui $E_j$ en $k+1$ transitions.

Affirmation 1 :

$P_{(X_0=E_i)}(X_{k+1}=E_j)=P_{(X_0=E_i)}((X_{k+1}=E_j)\cap (X_{k}=A))+P_{(X_0=E_i)}((X_{k+1}=E_j)\cap (X_{k}=B))$

$=P_{(X_0=E_i)}(X_{k}=A)\times P_{(X_k=A)}(X_{k+1}=E_j)+P_{(X_0=E_i)}(X_{k}=B)\times P_{(X_k=B)}(X_{k+1}=E_j)$

Ainsi :

Affirmation 2 :

$P_{(X_0=E_i)}(X_{k+1}=E_j)=P_{(X_0=E_i)}(X_{k}=A)\times T_{1j}+P_{(X_0=E_i)}(X_{k}=B)\times T_{2j}$.

Or, $T^{k+1}=T^k\times T$, ainsi :

Affirmation 3 : $T^{k+1}_{ij}=P_{(X_0=E_i)}(X_{k}=A)\times T_{1j}+P_{(X_0=E_i)}(X_{k}=B)\times T_{2j}$.

Dès lors, $T^{k+1}_{ij}=P_{(X_0=E_i)}(X_{k+1}=E_j)$.

En notant $A$ et $B$, les deux états possibles, on a bien :

$T^{k+1} = \begin{pmatrix} P_{(X_0=A)}(X_{k+1}=A) &P_{(X_0=A)}(X_{k+1}=B) \\ P_{(X_0=B)}(X_{k+1}=A)& P_{(X_0=B)}(X_{k+1}=B)\end{pmatrix}$.

Ainsi, on a démontré que le coefficient de la ligne $i$ et de la colonne $j$ de la matrice

$T^{k+1}$ est la probabilité de passer de l'état $E_i$ à celui $E_j$ en $k+1$ transitions".

La propriété est donc héréditaire.

Conclusion : pour tout entier naturel $n\ge 1$, le coefficient de la ligne $i$ et de la colonne $j$ de la matrice $T^n$ est la probabilité de passer de l'état $E_i$ à celui $E_j$ en $n$ transitions.

-

Justifier l'affirmation 1.

-

Quel élément de la définition d'une chaîne de Markov permet de justifier l'affirmation 2 ?

-

Exprimer les coefficients de la matrice $T^k \times T$ en fonction des coefficients de la matrice $T$ et de ceux de $T^k$ pour justifier l'affirmation 3.

Pour tout entier naturel $n$ non nul, $P_n=P_0 T^n$.

Démontrer ce résultat dans le cas de deux états $A$ et $B$.

Un internaute navigue sur un mini Web composé de trois pages. Ces pages possèdent des liens hypertextes qui

permettent de passer de certaines à d'autres par simple clic.

Voici la structure obtenue avec ces liens :

-

la page A contient 3 liens : 2 menant à la page B et 1 à la page C,

-

la page B contient 4 liens : 2 vers la page A, 1 vers elle-même et 1 vers la page C,

-

la page C contient 2 liens : 1 vers la page A et 1 vers la page B.

-

Représenter la situation par un graphe probabiliste.

-

Déterminer la matrice de transition $T$ associée à ce graphe probabiliste.

-

On admet que $T^2=\begin{pmatrix} \frac{1}{2}&\frac{1}{3}&\frac{1}{6}\\ \frac{1}{4}&\frac{25}{48}&\frac{11}{48} \\ \frac{1}{4}&\frac{11}{24}&\frac{7}{24}\end{pmatrix}$.

Quelle est la signification concrète de $T^2_{23}=\frac{11}{48}$ ?

-

L'internaute est sur la page A et effectue 10 clics.

Sur quelle page a-t-il le plus de chance d'arriver ? Justifier.

Étude asymptotique

Soit $(X_n)$ une chaîne de Markov à 2 ou 3 états de matrice de transition $T$.

S'il existe un entier naturel $n$ tel que la matrice $T^n$ ne contient pas de 0 alors la suite $(P_n)$

converge vers l'unique matrice $\pi$ vérifiant $\pi T=\pi$ et telle que tous ses coefficients sont compris entre 0 et 1

et telle que leur somme donne 1.

De plus, cette limite $\pi$ ne dépend pas de la distribution initiale $P_0$.

Dire que la matrice $T^n$ ne contient pas de 0 signifie que l'on peut passer de n'importe quel état à n'importe quel autre en exactement $n$ étapes.

En particulier pour $n=1$, si la matrice de transition $T$ ne contient pas de 0 alors la suite $(P_n)$ converge vers une telle matrice $\pi$ vérifiant $\pi T=\pi$.

En cas d'existence, une telle distribution $\pi$ est appelée la distribution invariante de la chaîne de Markov.

On reprend l'exercice sur le surf dans un mini Web avec la notation $T$ pour sa matrice de transition.

-

Soit $P$ la matrice définie par $P=\begin{pmatrix} \frac{1}{3}&\frac{4}{9}&\frac{2}{9}\end{pmatrix}$.

Calculer le produit matriciel $P T$. -

Que pouvez-vous en déduire ?

-

On considère un internaute qui navigue sur ce mini Web. Il part d'une page quelconque.

Sur quelle page a-t-il le plus de chance de se trouver à très long terme ?

Sur quelle page a-t-il le moins de chance de se trouver à très long terme ?

L'algorithme de PageRank® qui a fait la fortune du groupe Google est une amélioration de la démarche vue dans cet exercice.

Un ordinateur a été programmé pour afficher une succession de lettres. Ces lettres sont soient des

consonnes (C), soit des voyelles (V).

On admet que le programme conduit à cette règle constante :

-

si une lettre est une voyelle, la suivante est encore une voyelle dans 50% cas.

-

si une lettre est une consonne, la suivante sera une voyelle avec une probabilité de 0.8.

-

Représenter la situation par un graphe probabiliste.

-

Déterminer la matrice de transition associée à ce graphe probabiliste.

-

On suppose que la première lettre est une voyelle.

Déterminer la probabilité que la dixième lettre soit une consonne. -

On pose $\pi=\begin{pmatrix} x&y \end{pmatrix}$.

Justifier que $\pi$ est la distribution invariante du système si, et seulement si, $(x;y)$ est solution du système : $\left \{ \begin{array}{rcl} 0.8x-0.5y&=&0 \\ x+y&=&1 \end{array} \right.$ -

En déduire la distribution invariante de ce système.

-

Interpréter le résultat.

Exercices

Déterminer dans chacun des cas si la suite $(X_n)$ est une chaîne de Markov.

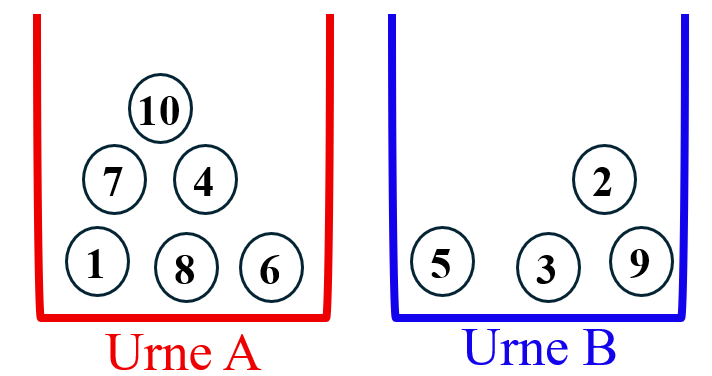

On dispose de deux urnes A et B contenant au départ dix boules numérotées de 1 à 10.

Voici un exemple de disposition possible :

$(X_n)$ désigne le nombre de boules dans A après l'étape $n$.

-

À chaque étape, on tire un numéro au hasard entre 1 et 10 et on change d'urne la boule choisie.

-

À chaque étape, on tire un numéro au hasard entre 1 et 10 et on change d'urne la boule choisie si son numéro est plus grand que la boule précédemment tirée.

-

À chaque étape, on tire un numéro au hasard entre 1 et 10 et on change d'urne la boule choisie si son numéro est plus grand parmi toutes les boules de l'urne A.

-

À chaque étape, on tire un numéro au hasard entre 1 et 10 et on change d'urne la boule choisie si son numéro est pair.

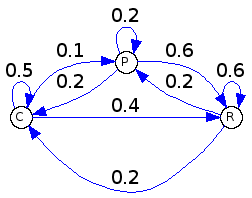

On étudie l'effet de la présence d'un requin bleu dans une zone dans laquelle ses proies possibles

sont des calmars ($C$), des poissions ($P$) et des petits requins ($R$).

Le choix de la proie ne dépend que de celle choisie précédemment.

On modélise la situation par une chaîne de Markov dont le grape pondéré est donné ci-dessous.

Au début de l'étude, le requin bleu a choisi un calmar comme proie.

-

Compléter la fonction

distributionci-dessous qui renvoie aprèsnproies dévorées la distribution $\pi_n$ lorsque la distribution initiale est(c p r).def distribution(c, p, r, n): for i in range(n): _c = c _p = p _r = r c = 0.5*_c + 0.2*_p + 0.2*_r ... ... return (c, p, r) -

Utiliser la fonction

distributionpour conjecturer une distribution invariante $\pi$. -

Déterminer la matrice de transition $T$ associée au modèle.

-

Vérifier que la distribution $\pi=\left( \dfrac{2}{7}\quad \dfrac{6}{35}\quad \dfrac{19}{35}\right)$ est bien une distribution invariante et que c'est la seule existante et qu'elle est indépendante de la proie initialement dévorée.

Le modèle des urnes d'Ehrenfest

fut développé en 1907 par Paul et Tatiana Ehrenfest afin de lever le "paradoxe" de l'irréversibilité dans la

dynamique des particules.

En effet, à notre échelle, la plupart des phénomènes macroscopiques sont irréversibles, alors que les lois de

la dynamique des particules sont réversibles.

Le modèle des urnes d'Ehrenfest cherche à montrer qu'un système comportant un grand nombre de particules aux évolutions

réversibles a une évolution macroscopique irréversible.

On le modélise avec deux urnes $U_1$ et $U_2$ et $k$ billes respectant un processus d'échange :

-

Au départ, l'urne $U_1$ contient les $k$ billes.

-

À chaque étape, on choisit au hasard une des $k$ billes et on la change d'urne.

Partie A : cas où $k=2$

On note $X_n$ le contenu de l'urne $U_1$ après $n$ étapes et on note $\pi_n$ la matrice ligne donnant la distribution de $X_n$.

-

Donner les distributions $\pi_0$ et $\pi_1$.

-

Représenter la chaîne de Markov des variables aléatoires $(X_n)$ à l'aide d'un graphe probabiliste à 3 états à définir.

-

Donner la matrice de transition $T$ associée à ce graphe probabiliste.

-

Montrer par récurrence que pour tout entier $m\ge 0$ : $\pi_{2m+1}=(0\ \ 1\ \ 0)$ et $\pi_{2m}=\left(\dfrac{1}{2}\ \ 0\ \ \dfrac{1}{2}\right)$

-

La suite $(\pi_n)$ est-elle convergente vers une distribution invariante ?

Partie B : cas général simulé

On suppose désormais qu'il y a $k$ billes, avec $k>2$.

On note $S_m$ la variable aléatoire donnant le nombre de billes présentes dans l'urne $U_1$

après $m$ échanges.

La fonction Ehrenfest ci-dessous doit simuler le contenu de l'urne $U_1$

dans le cas où il a $k$ billes dans le système et n échanges et doit

renvoyer la liste S

correspondant aux différentes valeurs prises par $S_m$ pour les étapes 0 à $n$.

import random

import matplotlib.pyplot as plt

def Ehrenfest(k, n):

"""

k est un entier correspond au nombre de billes dans l'ensemble des deux urnes

n est le nombre d'échanges en tout.

"""

U1 = [i for i in range(1, k+1)] # ligne 9

S = ... # liste contenant la succession des nombres de billes dans l'urne U1

for j in range(n):

num_bille = random.randint(1, k)

if num_bille in U1:

U1.remove(num_bille) # suppression de num_bille de l'urne U1

else:

...

S.append(...)

return S-

Quel est rôle de la ligne 9 du script ci-dessus ?

U1 = [i for i in range(1, k+1)] # ligne 9 -

Compléter la fonction

Ehrenfestau niveau des pointillés. -

Tester la fonction en exécutant

print(Ehrenfest(500, 1000)).

En regardant les dernières valeurs de la liste affichée, que pouvez-vous conjecturer sur la répartition des $k$ billes au bout d'un grand nombre d'échange ? -

Rajouter les lignes suivantes à la suite du script précédent :

# pour le tracé d'une courbe représentant Sn en fonction de n x = [i for i in range(10001)] y = Ehrenfest(500, 10000) plt.clf() # pour effacer tout tracé précédent plt.xlim(0,10000) # pour fixer l'affichage en abscisses entre 0 et 10000 plt.ylim(0,500) # pour fixer l'affichage en ordonnées entre 0 et 500 plt.gca().yaxis.set_ticks(range(0, 501, 50)) # pour imposer une graduation de 50 en 50 en ordonnées plt.gca().yaxis.grid(True, which = 'both', color = 'gray', zorder = 0) # pour dessiner les lignes liées aux graduations en ordonnées plt.plot(x,y) plt.show()Exécuter le script complet pour visualiser l'évolution du nombre de billes dans l'urne $U_1$ sur un grand nombre d'échanges.

-

Modifier le script afin d'étudier l'évolution de l'urne pour différentes valeurs de $k$ et de $n$.

-

Comment semble se comporter la suite $(S_n)$ lorsque $n$ tend vers $+\infty$ ?

Les différents

auteurs mettent l'ensemble du site à disposition selon les termes de la licence Creative

Commons Attribution - Pas d’Utilisation Commerciale - Partage dans les Mêmes Conditions 4.0

International